Die CPU-basierte Berechnung des optischen Flusses dauert auf der Test-Workstation bis zu zwei Tage. Die Qualität der Ergebnisse fällt sehr unterschiedlich aus. Sie ist abhängig vom Eingangsvideomaterial, dem gewählten Bildstil und den entsprechenden neural-style-Parametern. Abstrakte Bildvorlagen wie etwa Lissitzkys PROUN-Werke oder das für Testzwecke benutzte Black and Violett Kandinskys führen rasch zu vordergründig recht erstaunlichen Ergebnissen. Allerdings kann es bei monochromen Flächen wie blauem Himmel oder bei schnellen Bewegungen bzw. Bewegungsunschärfe zur Artefaktbildung sowie Stil- bzw. Farbsprüngen kommen. Dieses Problem tritt auch bei Stilvorlagen auf, die eher skizzenhafter Natur sind.

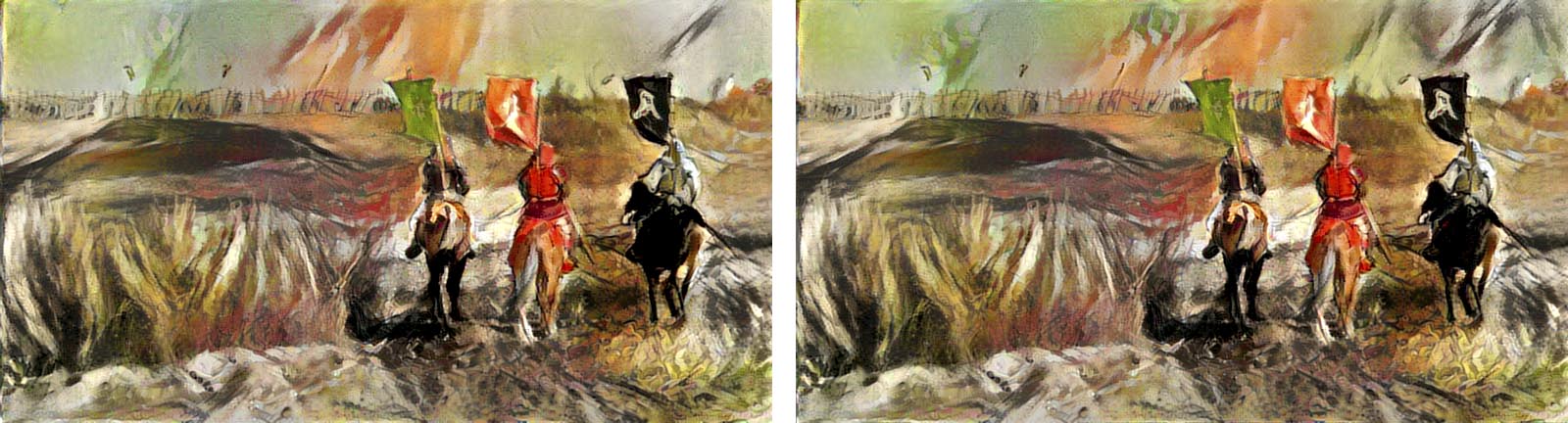

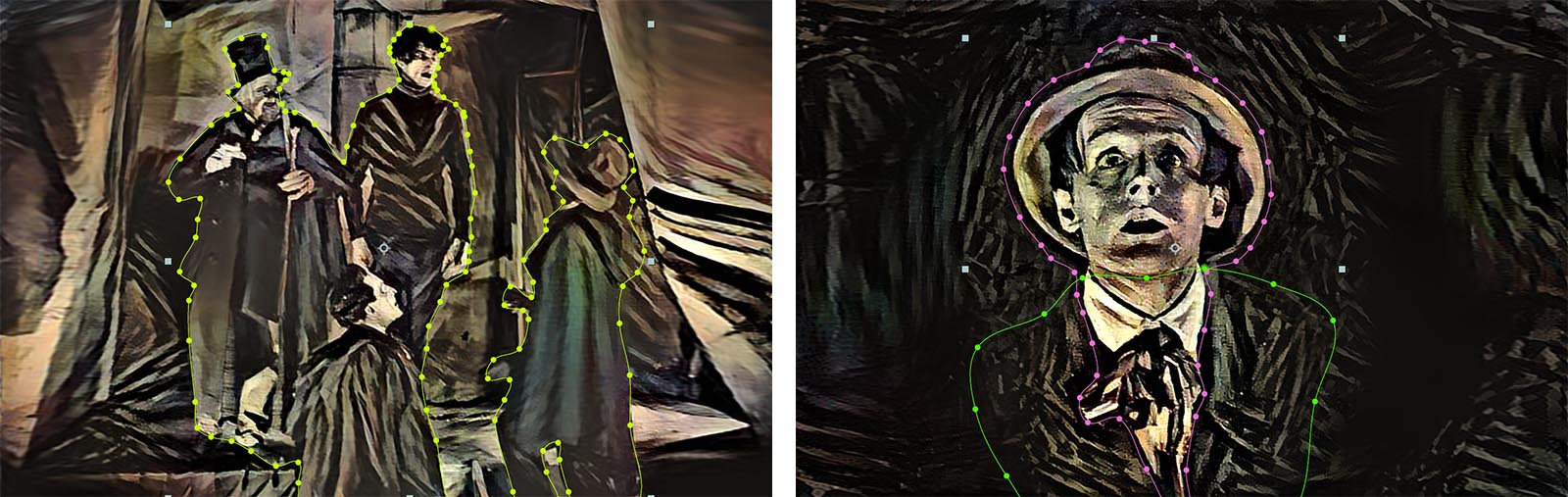

Das Beispiel mit zwei aufeinanderfolgenden Bildern aus Kagemusha zeigt, dass die Übergänge im Vorder- und Mittelgrund sehr konsistent sind, während Farben und Flächen im monochromen Blau des Himmels eher beliebig verteilt werden. Abhilfe schafft hier nur das Freistellen und Ersetzen des Himmels in After Effects. Zu diesem Zweck wird die Kamerabewegung erfasst und auf ein neu berechnetes Standbild des Himmels übertragen. Ähnliche Probleme gibt es auch beim Kabinett des Dr. Caligari und bei Pans Labyrinth. Hier sind es vor allem die dunklen Schattenbereiche, die zu nicht-konsistenten Übergängen führen. Teilweise müssen Vordergründe und Hintergründe getrennt berechnet und in After Effects wieder zusammengeführt werden.

Das Kabinett des Dr. Caligari: Animierte Masken

Das Kabinett des Dr. Caligari: Animierte Masken

Bei einer Spieldauer von einer Minute mit einer Bildrate von 24 Bildern pro Sekunde wären insgesamt 1440 Einzelbilder zu berechnen. Auf dem Testsystem würde die Berechnung pro FullHD-Bild knapp 20 Minuten dauern. Die Rechenzeit pro Filmminute läge damit bei knapp 480 Stunden, also 20 Tagen. Um diese Zeit zu reduzieren gibt es mehrere Möglichkeiten. Zum einen können parallel mehrere Titan-X-Grafikkarten für die GPU-Berechnung eingesetzt werden, zum anderen kann die Qualität des Stiltransfers mit einem anderen Modell (NIN-Imagenet) oder einem anderen Optimizer (adam anstatt lbfgs) herabgesetzt und damit die Berechnung beschleunigt werden. Mittlerweile hat Justin Johnson auf GitHub auch eine schnellere Torch-Implementierung vorgestellt, die er fast-neural-style nennt. Bei der Erstellung der vorliegenden Clips konnte sie jedoch nicht berücksichtigt werden.

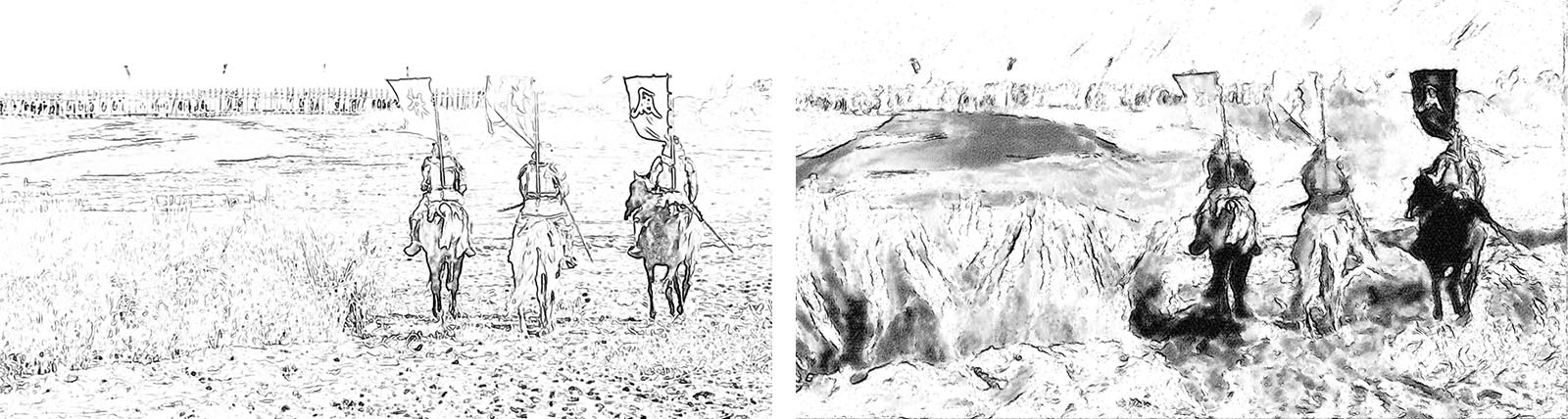

Für die hier gezeigten Beispiele werden Bilder mit einer horizontalen Länge von 800 Pixel berechnet und anschließend in After Effects (Detail-preserving Upscale) oder VirtualDub (Lanczos oder WarpResize) skaliert. Insbesondere die Skalierung mit WarpResize ermöglicht scharf abgegrenzte Kanten. Als nachteilig erweist sich jedoch die damit verbundene Skalierung der Pinselstriche, so dass der Malduktus nicht immer maßstabsgetreu übertragen wird. Dieses Problem kann etwas kaschiert werden, indem die skalierten Bilder in Photoshop, After Effects (ToonIt), Studio Artist oder FotoSketcher mit entsprechenden Malstilen nachbearbeitet und zum Überlagern der Originalbilder verwendet werden. Zu definitiv besseren Ergebnissen führt jedoch zweifelsfrei die rechenintensive Ausgabe in Originalgröße.

Strichzeichnungen für die Überlagerung des Originalbildes

Strichzeichnungen für die Überlagerung des Originalbildes

Ganz ähnlich verhält es sich mit der Bildrate, die von 15 fps wieder auf 24 fps hochgesetzt werden muss. Bei den älteren Filmbeispielen wie Panzerkreuzer Potemkin oder Metropolis ist das recht unproblematisch, da auch eine Bildverdopplung kaum auffällt. Anders verhält es sich dagegen bei bewegungsintensiven Clips wie Pans Labyrinth oder Frida, bei denen die fehlenden Zwischenbilder mit Hilfe von Werkzeugen wie Timewarp (After Effects) oder Twixtor extrahiert bzw. interpoliert werden müssen.

Installation von neural-style

Arbeiten mit neural-style

Stiltransfer für Videoclips

Postproduktion

Alternative Techniken